Тестирование оптических серверных адаптеров MT-X520-DA производилось с целью:

• Определения совместимости серверных адаптеров с аппаратным обеспечением

• Определения совместимости серверных адаптеров со стандартным программным обеспечением

• Определение производительности серверных адаптеров

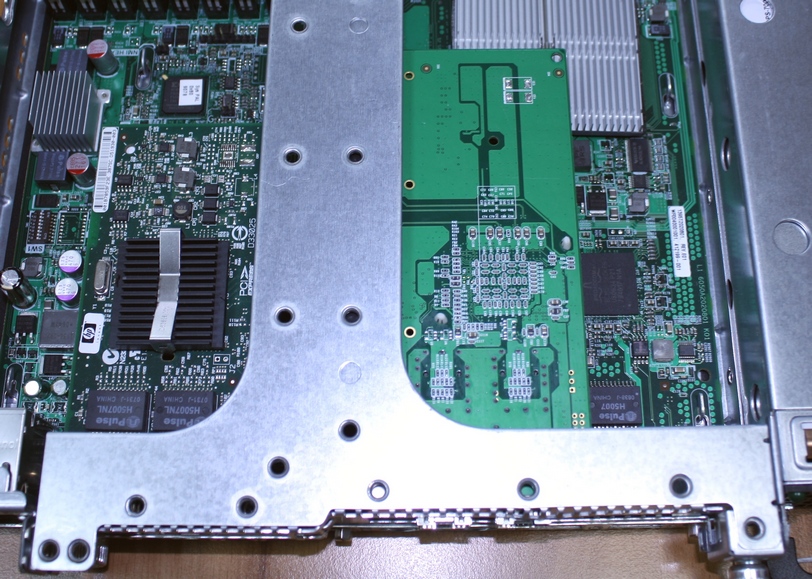

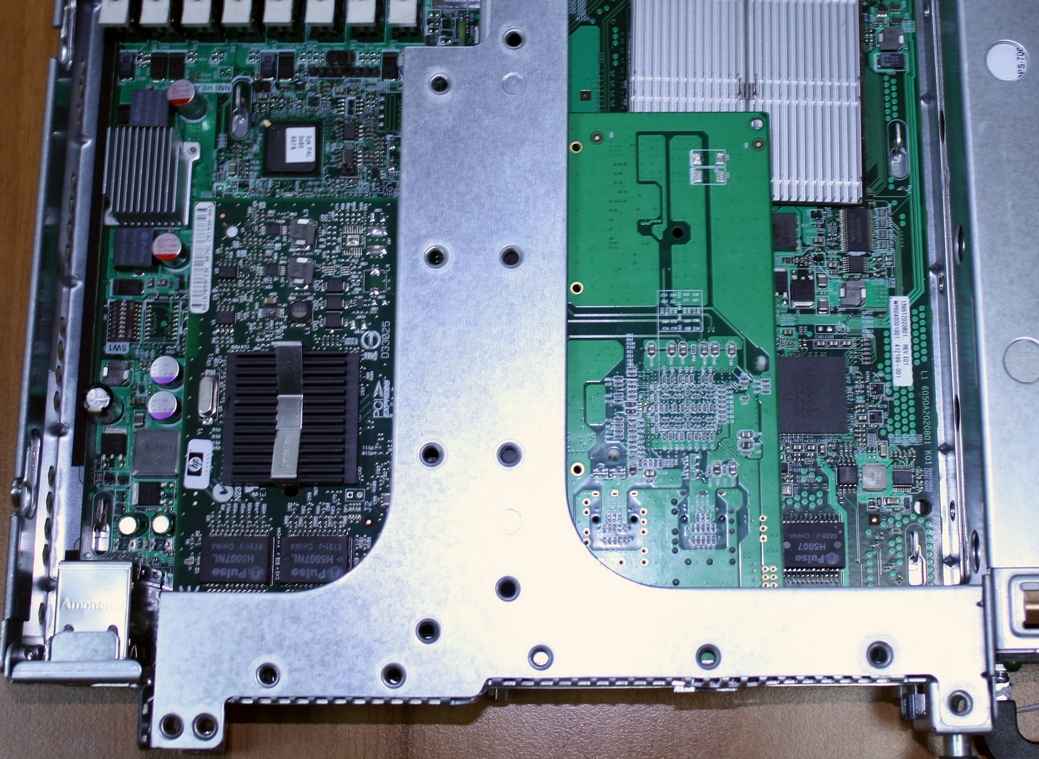

В качестве аппаратной платформы для тестирования использовались сервера HP DL 360G5 со следующими характеристиками:

• Тип процессора: Intel(R) Xeon(R) 5110 @ 1.60GHz

• Количество процессоров: 2

• Объем оперативной памяти: 4Gb

Сервера соединялись напрямую при помощи активного патчкорда MT-SFPp-10G-PDAC-03-CD

В качестве программного обеспечения использовалась операционная система Oracle Linux 6 (86_x64)

Использовались следующие программы и утилиты:

• lspci – вывод информации о PCI шинах и подключенных устройствах

• lsmod – вывод информации о загруженных модулях kernel

• modinfo ixgbe – вывод информации о драйвере Intel

• ethtool – команда для управления сетевыми адаптерами

• iperf – утилита для тестирования сетевых соединений

• top – команда для выводе информации о процессах и потребляемых ими ресурсах

Совместимость с аппаратным обеспечением

Однопортовый адаптер MT-X520-DA1

Установился легко и без проблем

#lspci определяет адаптер как:

Ethernet controller: Intel Corporation Device 1557 (rev 01)

Двухпортовый адаптер MT-X520-DA2

Установился с усилием.

Причина – положение разъемов для SFP. Для установки пришлось слегка подогнуть верхнюю планку окна.

# lspci определяет адаптер как:

13:00.0 Ethernet controller: Intel Corporation 82599EB 10-Gigabit SFI/SFP+ Network Connection (rev 01)

13:00.1 Ethernet controller: Intel Corporation 82599EB 10-Gigabit SFI/SFP+ Network Connection (rev 01)

Таким образом, сетевые адаптеры MT-X520-DA полностью совместимы с аппаратным обеспечением серверов.

Совместимость с программным обеспечением:

Однопортовый адаптер MT-X520-DA1:

Адаптер определяется стандартным драйвером Intel. Все утилиты работают с адаптером в штатном режиме.

#lsmod

ixgbe 200237 0

dca 7116 1 ixgbe

mdio 4698 1 ixgbe

# modinfo ixgbe

filename: /lib/modules/2.6.39-200.24.1.el6uek.x86_64/kernel/drivers/net/ixgbe/ixgbe.ko

version: 3.6.7-k

license: GPL

description: Intel(R) 10 Gigabit PCI Express Network Driver

author: Intel Corporation, <linux.nics@intel.com>

srcversion: 780FD4AF454545ABE4FCE06

alias: pci:v00008086d0000154Asv*sd*bc*sc*i*

alias: pci:v00008086d00001557sv*sd*bc*sc*i*

alias: pci:v00008086d0000154Fsv*sd*bc*sc*i*

alias: pci:v00008086d0000154Dsv*sd*bc*sc*i*

alias: pci:v00008086d00001528sv*sd*bc*sc*i*

alias: pci:v00008086d000010F8sv*sd*bc*sc*i*

alias: pci:v00008086d0000151Csv*sd*bc*sc*i*

alias: pci:v00008086d00001529sv*sd*bc*sc*i*

alias: pci:v00008086d0000152Asv*sd*bc*sc*i*

alias: pci:v00008086d000010F9sv*sd*bc*sc*i*

alias: pci:v00008086d00001514sv*sd*bc*sc*i*

alias: pci:v00008086d00001507sv*sd*bc*sc*i*

alias: pci:v00008086d000010FBsv*sd*bc*sc*i*

alias: pci:v00008086d00001517sv*sd*bc*sc*i*

alias: pci:v00008086d000010FCsv*sd*bc*sc*i*

alias: pci:v00008086d000010F7sv*sd*bc*sc*i*

alias: pci:v00008086d00001508sv*sd*bc*sc*i*

alias: pci:v00008086d000010DBsv*sd*bc*sc*i*

alias: pci:v00008086d000010F4sv*sd*bc*sc*i*

alias: pci:v00008086d000010E1sv*sd*bc*sc*i*

alias: pci:v00008086d000010F1sv*sd*bc*sc*i*

alias: pci:v00008086d000010ECsv*sd*bc*sc*i*

alias: pci:v00008086d000010DDsv*sd*bc*sc*i*

alias: pci:v00008086d0000150Bsv*sd*bc*sc*i*

alias: pci:v00008086d000010C8sv*sd*bc*sc*i*

alias: pci:v00008086d000010C7sv*sd*bc*sc*i*

alias: pci:v00008086d000010C6sv*sd*bc*sc*i*

alias: pci:v00008086d000010B6sv*sd*bc*sc*i*

depends: mdio,dca

vermagic: 2.6.39-200.24.1.el6uek.x86_64 SMP mod_unload modversions

parm: max_vfs:Maximum number of virtual functions to allocate per physical function (uint)

parm: allow_unsupported_sfp:Allow unsupported and untested SFP+ modules on 82599-based adapters (uint)

без подключения (без SFP и кабеля):

# ethtool eth0

Settings for eth0:

Supported ports: [ FIBRE ]

Supported link modes: 10000baseT/Full

Supports auto-negotiation: No

Advertised link modes: 10000baseT/Full

Advertised pause frame use: No

Advertised auto-negotiation: No

Speed: Unknown!

Duplex: Unknown! (255)

Port: Other

PHYAD: 0

Transceiver: external

Auto-negotiation: off

Supports Wake-on: d

Wake-on: d

Current message level: 0x00000007 (7)

Link detected: no

Двухпортовый адаптер MT-X520-DA2

Адаптер также определяется стандартным драйвером Intel. Все утилиты работают с адаптером в штатном режиме.

# lspci

13:00.0 Ethernet controller: Intel Corporation 82599EB 10-Gigabit SFI/SFP+ Network Connection (rev 01)

13:00.1 Ethernet controller: Intel Corporation 82599EB 10-Gigabit SFI/SFP+ Network Connection (rev 01)

# lsmod

ixgbe 200237 0

dca 7116 1 ixgbe

mdio 4698 1 ixgbe

# modinfo ixgbe

filename: /lib/modules/2.6.39-200.24.1.el6uek.x86_64/kernel/drivers/net/ixgbe/ixgbe.ko

version: 3.6.7-k

license: GPL

description: Intel(R) 10 Gigabit PCI Express Network Driver

author: Intel Corporation, <linux.nics@intel.com>

srcversion: 780FD4AF454545ABE4FCE06

alias: pci:v00008086d0000154Asv*sd*bc*sc*i*

alias: pci:v00008086d00001557sv*sd*bc*sc*i*

alias: pci:v00008086d0000154Fsv*sd*bc*sc*i*

alias: pci:v00008086d0000154Dsv*sd*bc*sc*i*

alias: pci:v00008086d00001528sv*sd*bc*sc*i*

alias: pci:v00008086d000010F8sv*sd*bc*sc*i*

alias: pci:v00008086d0000151Csv*sd*bc*sc*i*

alias: pci:v00008086d00001529sv*sd*bc*sc*i*

alias: pci:v00008086d0000152Asv*sd*bc*sc*i*

alias: pci:v00008086d000010F9sv*sd*bc*sc*i*

alias: pci:v00008086d00001514sv*sd*bc*sc*i*

alias: pci:v00008086d00001507sv*sd*bc*sc*i*

alias: pci:v00008086d000010FBsv*sd*bc*sc*i*

alias: pci:v00008086d00001517sv*sd*bc*sc*i*

alias: pci:v00008086d000010FCsv*sd*bc*sc*i*

alias: pci:v00008086d000010F7sv*sd*bc*sc*i*

alias: pci:v00008086d00001508sv*sd*bc*sc*i*

alias: pci:v00008086d000010DBsv*sd*bc*sc*i*

alias: pci:v00008086d000010F4sv*sd*bc*sc*i*

alias: pci:v00008086d000010E1sv*sd*bc*sc*i*

alias: pci:v00008086d000010F1sv*sd*bc*sc*i*

alias: pci:v00008086d000010ECsv*sd*bc*sc*i*

alias: pci:v00008086d000010DDsv*sd*bc*sc*i*

alias: pci:v00008086d0000150Bsv*sd*bc*sc*i*

alias: pci:v00008086d000010C8sv*sd*bc*sc*i*

alias: pci:v00008086d000010C7sv*sd*bc*sc*i*

alias: pci:v00008086d000010C6sv*sd*bc*sc*i*

alias: pci:v00008086d000010B6sv*sd*bc*sc*i*

depends: mdio,dca

vermagic: 2.6.39-200.24.1.el6uek.x86_64 SMP mod_unload modversions

parm: max_vfs:Maximum number of virtual functions to allocate per physical function (uint)

parm: allow_unsupported_sfp:Allow unsupported and untested SFP+ modules on 82599-based adapters (uint)

без подключения (без SFP и кабеля):

# ethtool eth2

Settings for eth2:

Supported ports: [ FIBRE ]

Supported link modes: 10000baseT/Full

Supports auto-negotiation: No

Advertised link modes: 10000baseT/Full

Advertised pause frame use: No

Advertised auto-negotiation: No

Speed: Unknown!

Duplex: Unknown! (255)

Port: Other

PHYAD: 0

Transceiver: external

Auto-negotiation: off

Supports Wake-on: d

Wake-on: d

Current message level: 0x00000007 (7)

Link detected: no

# ethtool eth3

Settings for eth3:

Supported ports: [ FIBRE ]

Supported link modes: 10000baseT/Full

Supports auto-negotiation: No

Advertised link modes: 10000baseT/Full

Advertised pause frame use: No

Advertised auto-negotiation: No

Speed: Unknown!

Duplex: Unknown! (255)

Port: Other

PHYAD: 0

Transceiver: external

Auto-negotiation: off

Supports Wake-on: d

Wake-on: d

Current message level: 0x00000007 (7)

Link detected: no

Таким образом, сетевые адаптеры MT-X520-DA полностью совместимы со стандартным программным обеспечением серверов.

Подключение интерфейсов (только физическое соединение)

Однопортовый адаптер MT-X520-DA1:

# ethtool eth0

Settings for eth0:

Supported ports: [ FIBRE ]

Supported link modes: 10000baseT/Full

Supports auto-negotiation: No

Advertised link modes: 10000baseT/Full

Advertised pause frame use: No

Advertised auto-negotiation: No

Speed: 10000Mb/s

Duplex: Full

Port: Other

PHYAD: 0

Transceiver: external

Auto-negotiation: off

Supports Wake-on: d

Wake-on: d

Current message level: 0x00000007 (7)

Link detected: no

Двухпортовый адаптер MT-X520-DA2

# ethtool eth3

Settings for eth3:

Supported ports: [ FIBRE ]

Supported link modes: 10000baseT/Full

Supports auto-negotiation: No

Advertised link modes: 10000baseT/Full

Advertised pause frame use: No

Advertised auto-negotiation: No

Speed: 10000Mb/s

Duplex: Full

Port: Other

PHYAD: 0

Transceiver: external

Auto-negotiation: off

Supports Wake-on: d

Wake-on: d

Current message level: 0x00000007 (7)

Link detected: no

Подключение интерфейсов (ethtool)

Однопортовый адаптер MT-X520-DA1:

# ethtool eth0

Settings for eth0:

Supported ports: [ FIBRE ]

Supported link modes: 10000baseT/Full

Supports auto-negotiation: No

Advertised link modes: 10000baseT/Full

Advertised pause frame use: No

Advertised auto-negotiation: No

Speed: 10000Mb/s

Duplex: Full

Port: Other

PHYAD: 0

Transceiver: external

Auto-negotiation: off

Supports Wake-on: d

Wake-on: d

Current message level: 0x00000007 (7)

Link detected: no

# ethtool -t eth0

The test result is PASS

The test extra info:

Register test (offline) 0

Eeprom test (offline) 0

Interrupt test (offline) 0

Loopback test (offline) 0

Link test (on/offline) 0

# ethtool -i eth0

driver: ixgbe

version: 3.6.7-k

firmware-version: 0x8000034a

bus-info: 0000:13:00.0

Двухпортовый адаптер MT-X520-DA2

# ethtool eth3

Settings for eth3:

Supported ports: [ FIBRE ]

Supported link modes: 10000baseT/Full

Supports auto-negotiation: No

Advertised link modes: 10000baseT/Full

Advertised pause frame use: No

Advertised auto-negotiation: No

Speed: 10000Mb/s

Duplex: Full

Port: Other

PHYAD: 0

Transceiver: external

Auto-negotiation: off

Supports Wake-on: d

Wake-on: d

Current message level: 0x00000007 (7)

Link detected: no

# ethtool -t eth3

The test result is PASS

The test extra info:

Register test (offline) 0

Eeprom test (offline) 0

Interrupt test (offline) 0

Loopback test (offline) 0

Link test (on/offline) 0

# ethtool -i eth2

driver: ixgbe

version: 3.6.7-k

firmware-version: 0x80000345

bus-info: 0000:13:00.1

# ethtool -i eth3

driver: ixgbe

version: 3.6.7-k

firmware-version: 0x80000345

bus-info: 0000:13:00.0

Таким образом, интерфейсы распознаются и подключаются успешно.

Тестирование скорости передачи данных.

Тестирование проводилось программой ipref. При этом замерялась скорость передачи данных на передающей и на принимающей сторонах. Поскольку на скорость передачи оказывала влияния не только производительность платы, но и производительность сервера, были проведены три теста – с одним, с двумя и тремя запущенными клиентами ipref.

Тест 1

одно приложение на сервере

одно приложение на клиенте

==========================================

Запущено клиентов = 1

1)сторона сервера

ipref

[root@localhost yum.repos.d]# iperf -s -p 80

————————————————————

Server listening on TCP port 80

TCP window size: 85.3 KByte (default)

————————————————————

[ 4] local 192.168.199.1 port 80 connected with 192.168.199.2 port 58040

[ ID] Interval Transfer Bandwidth

[ 4] 0.0-30.0 sec 18.2 GBytes 5.21 Gbits/sec

eth0 Link encap:Ethernet HWaddr 04:00:A8:00:10:D3

inet addr:192.168.199.1 Bcast:192.168.199.255 Mask:255.255.255.0

inet6 addr: fe80::600:a8ff:fe00:10d3/64 Scope:Link

UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1

RX packets:16460390 errors:0 dropped:0 overruns:0 frame:0

TX packets:13653180 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:440245396142 (410.0 GiB) TX bytes:901672385 (859.9 MiB)

нагрузка CPU (top)

top – 12:44:57 up 19 days, 18:14, 2 users, load average: 0.00, 0.01, 0.05

Tasks: 100 total, 1 running, 99 sleeping, 0 stopped, 0 zombie

Cpu(s): 0.3%us, 10.5%sy, 0.0%ni, 89.1%id, 0.0%wa, 0.0%hi, 0.1%si, 0.0%st

Mem: 4053096k total, 893244k used, 3159852k free, 157148k buffers

Swap: 4063228k total, 0k used, 4063228k free, 504152k cached

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

11743 root 20 0 165m 3020 824 S 61.8 0.1 0:17.08 iperf

2)сторона клиента

ipref

[root@localhost iperf-2.0.4]# iperf -c 192.168.199.1 -p 80 -t 30

————————————————————

Client connecting to 192.168.199.1, TCP port 80

TCP window size: 16.0 KByte (default)

————————————————————

[ 3] local 192.168.199.2 port 58040 connected with 192.168.199.1 port 80

[ ID] Interval Transfer Bandwidth

[ 3] 0.0-30.0 sec 18.2 GBytes 5.21 Gbits/sec

[root@localhost iperf-2.0.4]#

eth3 Link encap:Ethernet HWaddr 04:00:A8:00:01:DA

inet addr:192.168.199.2 Bcast:192.168.199.255 Mask:255.255.255.0

inet6 addr: fe80::600:a8ff:fe00:1da/64 Scope:Link

UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1

RX packets:13653174 errors:0 dropped:0 overruns:0 frame:0

TX packets:304783179 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:901673111 (859.9 MiB) TX bytes:459274698998 (427.7 GiB)

нагрузка CPU (top)

Tasks: 109 total, 1 running, 108 sleeping, 0 stopped, 0 zombie

Cpu(s): 0.4%us, 22.4%sy, 0.0%ni, 75.3%id, 0.0%wa, 0.0%hi, 2.0%si, 0.0%st

Mem: 4053096k total, 893536k used, 3159560k free, 156688k buffers

Swap: 4063228k total, 0k used, 4063228k free, 501940k cached

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

9048 root 20 0 96064 976 828 S 100.0 0.0 0:11.60 iperf

Тест 2

одно приложение на сервере

два приложение на клиенте

==========================================

Запущено клиентов = 2

1)сторона сервера

ipref

[root@localhost yum.repos.d]# iperf -s -p 80

————————————————————

Server listening on TCP port 80

TCP window size: 85.3 KByte (default)

————————————————————

[ 5] local 192.168.199.1 port 80 connected with 192.168.199.2 port 58045

[ 4] local 192.168.199.1 port 80 connected with 192.168.199.2 port 58046

[ ID] Interval Transfer Bandwidth

[ 5] 0.0-30.0 sec 16.2 GBytes 4.65 Gbits/sec

[ ID] Interval Transfer Bandwidth

[ 4] 0.0-31.8 sec 16.1 GBytes 4.35 Gbits/sec

[SUM] 0.0-31.8 sec 32.3 GBytes 8.74 Gbits/sec

[root@localhost yum.repos.d]# iperf -s -p 80

eth0 Link encap:Ethernet HWaddr 04:00:A8:00:10:D3

inet addr:192.168.199.1 Bcast:192.168.199.255 Mask:255.255.255.0

inet6 addr: fe80::600:a8ff:fe00:10d3/64 Scope:Link

UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1

RX packets:19545052 errors:0 dropped:0 overruns:0 frame:0

TX packets:16593077 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:544888741674 (507.4 GiB) TX bytes:1095870811 (1.0 GiB)

нагрузка CPU (top)

top – 12:51:51 up 19 days, 18:21, 2 users, load average: 0.00, 0.01, 0.05

Tasks: 100 total, 1 running, 99 sleeping, 0 stopped, 0 zombie

Cpu(s): 0.6%us, 24.0%sy, 0.0%ni, 75.1%id, 0.0%wa, 0.0%hi, 0.2%si, 0.0%st

Mem: 4053096k total, 891036k used, 3162060k free, 157160k buffers

Swap: 4063228k total, 0k used, 4063228k free, 504156k cached

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

11763 root 20 0 237m 1016 836 S 119.6 0.0 1:23.16 iperf

2) сторона клиента

ipref

процесс 1

[root@localhost iperf-2.0.4]# iperf -c 192.168.199.1 -p 80 -t 30

————————————————————

Client connecting to 192.168.199.1, TCP port 80

TCP window size: 16.0 KByte (default)

————————————————————

[ 3] local 192.168.199.2 port 58045 connected with 192.168.199.1 port 80

[ ID] Interval Transfer Bandwidth

[ 3] 0.0-30.0 sec 16.2 GBytes 4.65 Gbits/sec

[root@localhost iperf-2.0.4]#

процесс 2

[root@test20 ~]# iperf -c 192.168.199.1 -p 80 -t 30

————————————————————

Client connecting to 192.168.199.1, TCP port 80

TCP window size: 16.0 KByte (default)

————————————————————

[ 3] local 192.168.199.2 port 58046 connected with 192.168.199.1 port 80

[ ID] Interval Transfer Bandwidth

[ 3] 0.0-30.0 sec 16.1 GBytes 4.62 Gbits/sec

[root@test20 ~]#

eth3 Link encap:Ethernet HWaddr 04:00:A8:00:01:DA

inet addr:192.168.199.2 Bcast:192.168.199.255 Mask:255.255.255.0

inet6 addr: fe80::600:a8ff:fe00:1da/64 Scope:Link

UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1

RX packets:16593071 errors:0 dropped:0 overruns:0 frame:0

TX packets:376952960 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:1095871537 (1.0 GiB) TX bytes:568477662384 (529.4 GiB)

нагрузка CPU (top)

top – 09:19:47 up 19 days, 1:51, 5 users, load average: 0.06, 0.06, 0.05

Tasks: 110 total, 1 running, 109 sleeping, 0 stopped, 0 zombie

Cpu(s): 0.5%us, 31.6%sy, 0.0%ni, 64.4%id, 0.0%wa, 0.0%hi, 3.5%si, 0.0%st

Mem: 4053096k total, 900536k used, 3152560k free, 156688k buffers

Swap: 4063228k total, 0k used, 4063228k free, 501940k cached

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

9060 root 20 0 96064 976 828 S 74.1 0.0 0:17.21 iperf

9063 root 20 0 96064 976 828 S 68.1 0.0 0:14.65 iperf

1 root 20 0 19400 1556 1244 S 0.0 0.0 0:01.60 init

============================================

Тест 3

одно приложение на сервере

три приложение на клиенте

==========================================

Запущено клиентов = 3

1)сторона сервера

ipref

[root@localhost yum.repos.d]# iperf -s -p 80

————————————————————

Server listening on TCP port 80

TCP window size: 85.3 KByte (default)

————————————————————

[ 4] local 192.168.199.1 port 80 connected with 192.168.199.2 port 58047

[ 5] local 192.168.199.1 port 80 connected with 192.168.199.2 port 58048

[ 6] local 192.168.199.1 port 80 connected with 192.168.199.2 port 58049

[ ID] Interval Transfer Bandwidth

[ 4] 0.0-30.0 sec 11.1 GBytes 3.19 Gbits/sec

[ ID] Interval Transfer Bandwidth

[ 5] 0.0-30.6 sec 11.0 GBytes 3.08 Gbits/sec

[ ID] Interval Transfer Bandwidth

[ 6] 0.0-31.3 sec 11.1 GBytes 3.05 Gbits/sec

[SUM] 0.0-31.3 sec 33.3 GBytes 9.11 Gbits/sec

eth0 Link encap:Ethernet HWaddr 04:00:A8:00:10:D3

inet addr:192.168.199.1 Bcast:192.168.199.255 Mask:255.255.255.0

inet6 addr: fe80::600:a8ff:fe00:10d3/64 Scope:Link

UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1

RX packets:20683876 errors:0 dropped:0 overruns:0 frame:0

TX packets:17416869 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:580705002314 (540.8 GiB) TX bytes:1150953555 (1.0 GiB)

нагрузка CPU (top)

top – 12:56:43 up 19 days, 18:26, 2 users, load average: 0.00, 0.01, 0.05

Tasks: 100 total, 1 running, 99 sleeping, 0 stopped, 0 zombie

Cpu(s): 0.5%us, 27.6%sy, 0.0%ni, 71.4%id, 0.0%wa, 0.0%hi, 0.4%si, 0.0%st

Mem: 4053096k total, 892788k used, 3160308k free, 157184k buffers

Swap: 4063228k total, 0k used, 4063228k free, 504156k cached

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

11789 root 20 0 309m 976 824 S 144.2 0.0 0:35.48 iperf

2)сторона клиента

ipref

процесс 1

[root@localhost iperf-2.0.4]# iperf -c 192.168.199.1 -p 80 -t 30

————————————————————

Client connecting to 192.168.199.1, TCP port 80

TCP window size: 16.0 KByte (default)

————————————————————

[ 3] local 192.168.199.2 port 58047 connected with 192.168.199.1 port 80

[ ID] Interval Transfer Bandwidth

[ 3] 0.0-30.0 sec 11.1 GBytes 3.19 Gbits/sec

[root@localhost iperf-2.0.4]#

процесс 2

[root@test20 ~]# iperf -c 192.168.199.1 -p 80 -t 30

————————————————————

Client connecting to 192.168.199.1, TCP port 80

TCP window size: 16.0 KByte (default)

————————————————————

[ 3] local 192.168.199.2 port 58048 connected with 192.168.199.1 port 80

[ ID] Interval Transfer Bandwidth

[ 3] 0.0-30.0 sec 11.0 GBytes 3.14 Gbits/sec

процесс 3

[root@test20 ~]# iperf -c 192.168.199.1 -p 80 -t 30

————————————————————

Client connecting to 192.168.199.1, TCP port 80

TCP window size: 601 KByte (default)

————————————————————

[ 3] local 192.168.199.2 port 58049 connected with 192.168.199.1 port 80

[ ID] Interval Transfer Bandwidth

[ 3] 0.0-30.0 sec 11.1 GBytes 3.19 Gbits/sec

[root@test20 ~]#

eth3 Link encap:Ethernet HWaddr 04:00:A8:00:01:DA

inet addr:192.168.199.2 Bcast:192.168.199.255 Mask:255.255.255.0

inet6 addr: fe80::600:a8ff:fe00:1da/64 Scope:Link

UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1

RX packets:17416863 errors:0 dropped:0 overruns:0 frame:0

TX packets:401639811 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:1150954281 (1.0 GiB) TX bytes:605848092806 (564.2 GiB)

нагрузка CPU (top)

top – 09:26:21 up 19 days, 1:57, 5 users, load average: 0.00, 0.03, 0.05

Tasks: 111 total, 1 running, 110 sleeping, 0 stopped, 0 zombie

Cpu(s): 0.4%us, 33.2%sy, 0.0%ni, 63.8%id, 0.0%wa, 0.0%hi, 2.6%si, 0.0%st

Mem: 4053096k total, 905684k used, 3147412k free, 156692k buffers

Swap: 4063228k total, 0k used, 4063228k free, 501944k cached

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

9094 root 20 0 96064 976 828 S 50.2 0.0 0:07.52 iperf

9097 root 20 0 96064 976 828 S 49.2 0.0 0:06.74 iperf

9100 root 20 0 96064 976 828 S 45.2 0.0 0:06.01 iperf

============================================

Таким образом, производительность серверных адаптеров составляет более 9.5 Gbps и соответствует заявленной.

Выводы по результатам тестирования

В результате тестирования было подтверждено, что серверные сетевые адаптеры MT-X520-DA:

- полностью совместимы со стандартным аппаратным и программным обеспечением

- производительность сетевых адаптеров составляет более 9.5 Gbps на канал

Таким образом, они могут быть рекомендованы к применению взамен оригинальных 10G сетевых адаптеров